(논문 요약) Scaling Laws for Precision (Paper)

핵심 내용

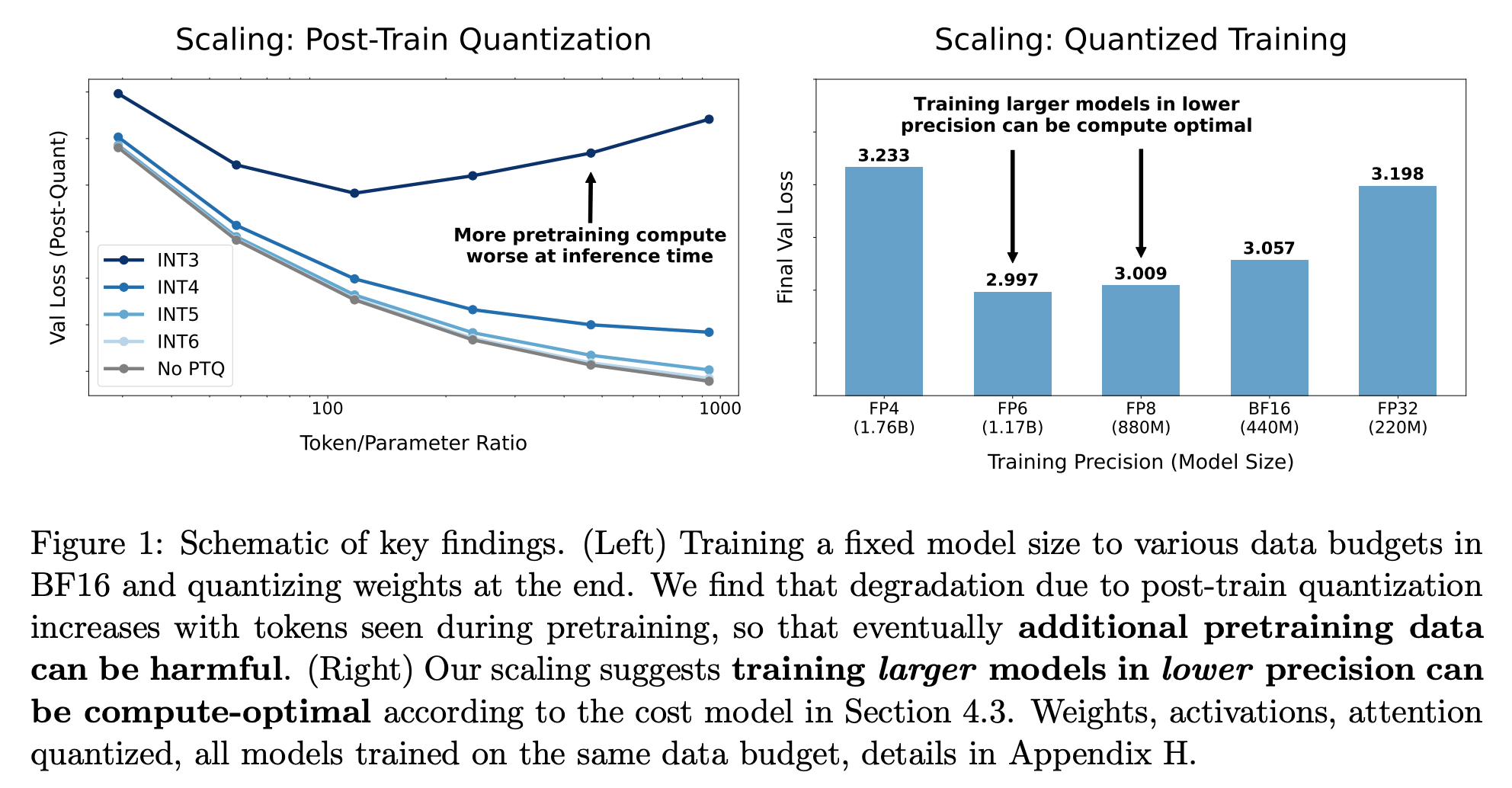

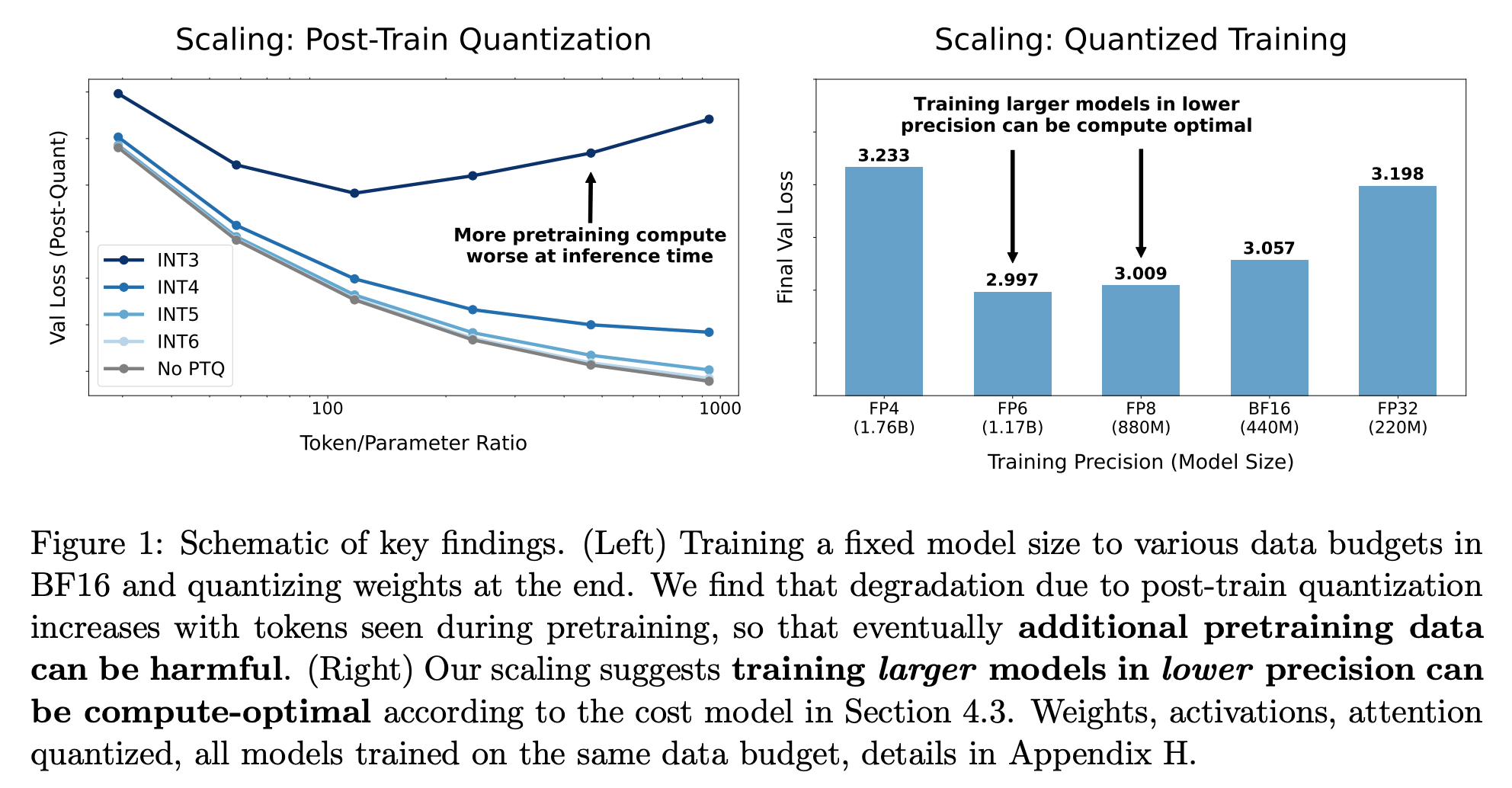

- Quantized 가 심한 모델은 더 많은 pretraining 이 성능을 해침

주어진 compute budget 에서 optimal param, quantization 존재

- precision 이 주어졌을때 loss 를 예측하는 식까지 도출하나, 실험한 모델 사이즈가 작음 (220M~1.76B)

(논문 요약) Scaling Laws for Precision (Paper)

주어진 compute budget 에서 optimal param, quantization 존재